电脑知识网10月16日消息,随着AI行业的快速发展,计算能力的需求也在急剧上升,无论是通过硬件技术,还是大规模AI集群建设,企业都在努力提升其AI处理能力,然而这也带来了巨大的能源消耗问题。

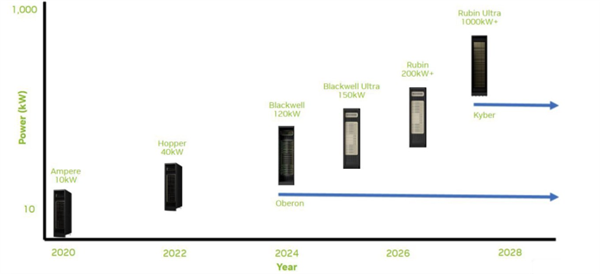

据分析师Ray Wang分享的数据,NVIDIA的AI服务器平台在每一代的更新中都经历了显著的功耗增长,从Ampere到Kyber,功耗八年间增长了100倍。

这种巨大的功耗增长主要归因于每一代每机架GPU数量的增加,以及每个GPU的TDP的提升。

例如在使用Hopper时,以每机架10KW的额定功率运行,而使用Blackwell时,由于GPU数量的增加,这一功率几乎提升至120KW。

除了GPU数量的增加,其他因素如先进的NVLink/NVSwitch网络架构、新一代机架设计以及持续的机架利用率,也导致了超大规模数据中心的能源消耗以惊人的速度增长。

如今,大型科技公司纷纷参与“谁拥有更大规模的AI机架”的竞赛,衡量标准已经从传统的计算能力转变为“吉瓦(GW)”,像OpenAI和Meta等公司计划在未来几年内增加超过10吉瓦的计算能力。

作为对比,AI超大规模企业消耗的1吉瓦能源,足以供应大约100万美国家庭,随着大型科技公司纷纷建设大规模数据中心,单个数据中心的能耗已经相当于一个中等国家或几个美国大州的用电量。

另外国际能源署(IEA)2025年的“能源与AI”研究报告估计,到2030年,AI的能源消耗将翻倍,几乎是电网增长速度的四倍。